近日,阿里达摩院正式开源大模型Video-LLaMA,论文、代码、交互demo都已开放。另外,在 Video-LLaMA 的项目主页中,研究团队还提供了中文版本的模型,让中文用户的体验更丝滑。据悉,Video-LLaMA 能够感知和理解视频中的视频和音频信号,并能理解用户输入的指令,完成一系列基于音视频的复杂任务,例如音视频描述、写作、问答等。

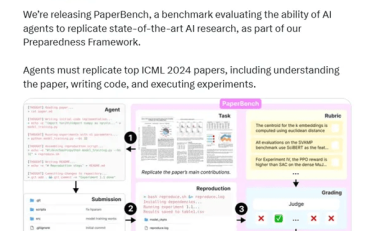

Video-LLaMA 采用了模块化设计原则,把视频中的视觉和音频模态信息映射到到大语言模型的输入空间中,以实现跨模态指令跟随的能力。与之前侧重于静态图像理解的大模型研究(MiNIGPT4,LLaVA)不同,Video-LLaMA 面临着视频理解中的两个挑战:捕捉视觉中的动态场景变化和整合视听信号。

为了捕捉视频中的动态场景变化,Video-LLaMA 引入了一个可插拔的视觉语言分支。该分支首先使用BLIP-2中预训练好的图片编码器得到每一帧图像的单独特征,再与对应的帧位置嵌入结合后,所有图像特征被送入 Video Q-Former,Video Q-Former将聚合帧级别的图像表示并且生成定长的综合视频表征。最后采用一个线性层将视频表征对齐到大语言模型的embedding空间。

至于视频中的声音信号,Video-LLaMA 使用音频 - 语言分支进行处理。首先从原始视频中均匀采样多个时长两秒的音频片段,并将每个片段转换为 128 维的梅尔频谱图。然后,采用强大的 ImageBind 作为音频编码器,单独提取每个声音片段的特征。在添加可学习的位置嵌入后,Audio Q-Former 将片段特征进行整体聚合,并生成固定长度的音频特征。与视觉语言分支类似,最后采用线性层将音频表征对齐到大语言模型的 embedding 空间。

总的来说,Video-LLaMA 作为一个具有综合视听能力的大模型,在音频视频理解领域取得了令人印象深刻的效果。相信随着研究者的不断攻坚,音视频理解模型会具有更广泛的实用价值。

AI俱乐部,致力于打造最专业的AI交流社群。

星球将分享:

1、ChatGPT的使用方法,最新资讯,商业价。

2、邀请顶尖行业大佬,每周给大家发现一个商业落地案例。

3、组织星球小伙伴一起参与实战项目,亲身感受AI浪潮。

4、系列课程和训练营,手把手带着大家去实操ChatGPT。

5、一些副业思考、创业案例、落地案例分享。

6、最早期、专业的AI交流社群。探讨未来关于ChatGPT的机遇,帮助大家解决遇到的问题。

如果有小伙伴感兴趣的话,可以一起加入星球哦!