日前,多模态生成式AI平台Runway宣布,旗下文本生成视频平台Gen-2正式公测,所有人都可以免费试用。

免费体验地址:https://runwayml.com/ai-magic-tools/gen-2/

早在今年3月份,Runway就已经发布了Gen-2,但是当时仅限于申请测试,这次则是面向所有人开放,吸引了全球用户的关注。在Gen-2之前,Runway曾经推出了Gen-1,相比于Gen-1来说,Gen-2功能强大、特效酷炫,支持文本生成视频、文本+图片生成视频、图片生成视频、视频风格化等操作。

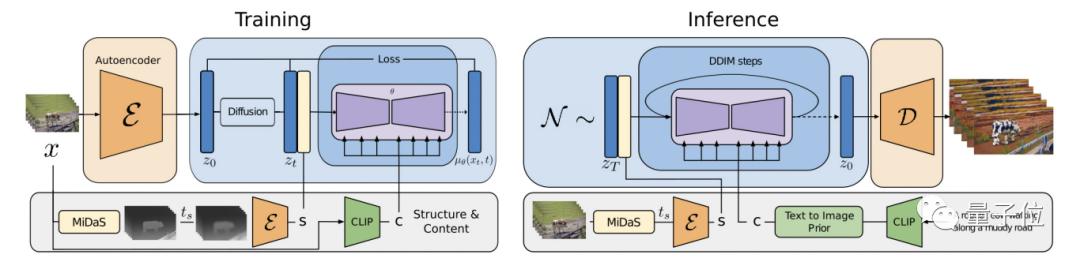

据Runway介绍,Gen-2采用的是扩散模型,通过在预训练图像模型中引入时间层,并在图像和视频数据上进行联合训练,完成了潜扩散模型到视频生成领域的扩展。其中也包括使用一种全新的引导方法完成了对生成结果时间一致性的精确控制。其架构如图所示:

在训练阶段,先用固定编码器将输入视频x编码为z0,并扩散为zt。

然后对MiDaS获得的深度图进行编码,提取出结构表示s;再用CLIP对其中一个帧进行编码来获取内容表示c。接着,在s的帮助下,模型学习反转潜空间中的扩散过程(其中s与c以及通过交叉注意块生成的c相连)。

在推理阶段,模型以相同的方式提供输入视频的结构s。为了通过文本生成内容,作者还通过一个prior将CLIP文本嵌入转换为图像嵌入。最终,Gen1可以生成细粒度可控的视频,也能对一些参考图像进行定制。

不过,一开始对公众发布的Gen1只能对已有视频进行编辑,Gen2才直接完成了文生视频的“蜕变”。并且一口气带来了另外7大功能,包括文本+参考图像生视频、静态图片转视频、视频风格迁移等等。

总体来说,Gen-2处于产品打磨阶段,无法达到抢专业视频制作者饭碗的地步。毕竟视频生成比文本、图片更加复杂难以控制。相信经过多次技术迭代和全球用户的深度反馈后,会达到ChatGPT、Midjourney那样的效果。