9月20日,上海人工智能实验室等机构发布书生·浦语大模型(InternLM)200亿参数版本InternLM-20B,并在阿里云魔搭社区(ModelScope)开源首发、免费商用。

开源地址:https://modelscope.cn/models/Shanghai_AI_Laboratory/internlm-20b

书生·浦语(InternLM)大语言模型由上海人工智能实验室联合多家机构共同推出。今年6月,InternLM千亿参数(104B)语言大模型首次发布,现已经历多轮升级;7月,上海人工智能实验室开源书生·浦语70亿参数的轻量级版本InternLM-7B,且在业内率先开源贯穿数据、预训练、微调、部署和评测的全链条工具体系。InternLM-7B也已上线魔搭社区。

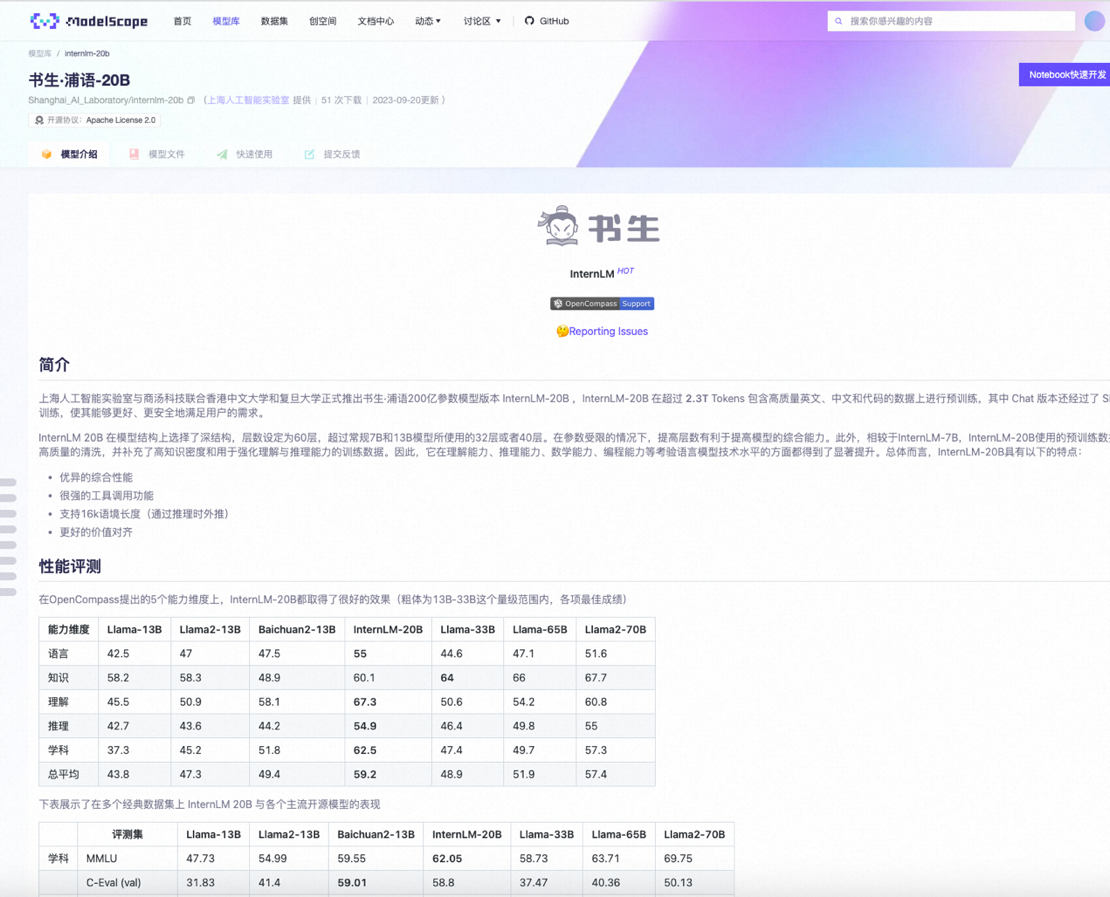

本次发布的InternLM-20B是一款中量级大模型,性能先进且应用便捷,模型基于2.3T Tokens预训练语料从头训练,相较于InternLM-7B,其理解能力、推理能力、数学能力、编程能力等都有显著提升。

相比于此前国内陆续开源的7B和13B规格模型,20B量级模型具备更强大的综合能力,复杂推理和反思能力尤为突出,能为实际应用场景提供更有力的性能支持;同时,20B量级模型可在单卡上进行推理,经过低比特量化后,可运行在单块消费级GPU上,因而在实际应用中更为便捷。

InternLM-20B拥有几大优势:

- 优异的综合性能:不仅全面领先相近量级的开源模型,且以不足1/3的参数量,测评成绩达到了Llama2-70B的水平。

- 强大的工具调用能力:支持数十类插件,上万个API功能,还具备代码解释和反思修正能力,为智能体(Agent)的构建提供了良好的技术基础。

- 更长的语境:实现了对长文理解、长文生成和超长对话的有效支持,同时支持16K语境长度。

- 更安全的价值对齐:在研发训练的过程中,研究团队进行了基于SFT和RLHF两阶段价值对齐,并通过专家红队的对抗训练大幅提高其安全性。

书生·浦语开源工具链也已全新升级,形成更完善的体系,包括预训练框架InternLM-Train、低成本微调框架XTuner、部署推理框架LMDeploy、评测框架OpenCompass以及面向场景应用的智能体框架Lagent。书生·浦语工具链将和开源数据平台OpenDataLab构成强大的开源工具及数据体系,为业界提供全链条研发与应用支持。

AI俱乐部,致力于打造最专业的AI交流社群。

星球将分享:

1、ChatGPT的使用方法,最新资讯,商业价。

2、邀请顶尖行业大佬,每周给大家发现一个商业落地案例。

3、组织星球小伙伴一起参与实战项目,亲身感受AI浪潮。

4、系列课程和训练营,手把手带着大家去实操ChatGPT。

5、一些副业思考、创业案例、落地案例分享。

6、最早期、专业的AI交流社群。探讨未来关于ChatGPT的机遇,帮助大家解决遇到的问题。

如果有小伙伴感兴趣的话,可以一起加入星球哦!