最近,OpenAI发布了最新GPT-4o多模态大模型,该模型将在未来几周内分阶段集成至OpenAI的各个产品之中。

GPT-4o在速度上比GPT-4 Trubo更快,价格也更便宜。GPT-4o能够在语音模式下达到“实时”响应状态,允许用户像与真人对话一样与ChatGPT交流,包括在机器人回应过程中打断它并提出新要求。

与现有模型相比,GPT-4o在视觉和音频理解方面也会更出色。GPT-4o可以在音频、视觉和文本中进行实时推理,接受文本、音频和图像的任何组合作为输入,并生成文本、音频和图像的任何组合进行输出。

新版本的核心提升

1、GPT-4级别的智能

ChatGPT 4o提供了与GPT-4相同的智能水平,但其运行速度更快,成本更低。OpenAI首席技术官Mira Murati强调,ChatGPT 4o的速度提高了2倍,成本降低了50%,并且在使用限额上提高了5倍。

2、支持多模态的增强

ChatGPT 4o在语音、文本和视觉处理方面进行了多项改进。不仅能更好地理解语音的语气,还能消除背景噪音,从而提供更自然的对话体验。此外,ChatGPT 4o还能在语音、文本和视觉之间进行推理,使其在处理多模态任务时表现更加出色。

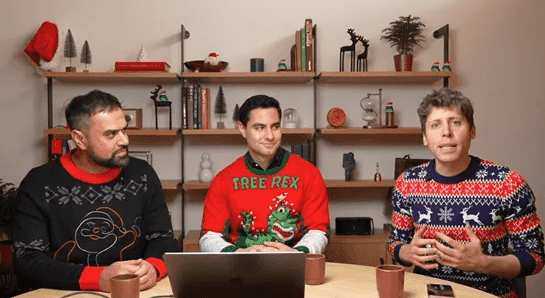

ChatGPT 4o的实时演示

1、实时语音对话

现场演示中,研究员Mark Chen通过实时语音对话展示了ChatGPT 4o的能力。他向ChatGPT咨询如何缓解紧张情绪,并进行了呼吸练习,ChatGPT给予了实时反馈。新模型能够识别语音中的情绪变化,并提供相应的建议,这在之前的版本中是无法实现的。

2、视觉能力展示

研究员Barrett Z展示了ChatGPT 4o的视觉能力。他写下一个线性方程式并向ChatGPT展示,ChatGPT通过分析图像,逐步引导他解决方程。这一功能展示了ChatGPT 4o在处理视觉内容方面的强大能力。

3、多语言支持和性能提升

ChatGPT 4o在50种不同语言的质量和速度上都有所提升,使全球用户都能享受到更高效和准确的AI服务。此外,Murati强调,付费用户将继续享有更高的使用限额,相较免费用户有多达5倍的容量限制。

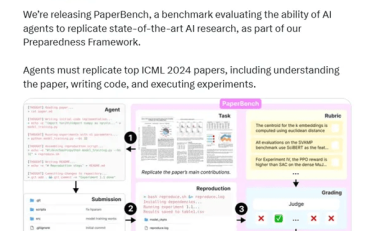

4、API集成和开发者支持

ChatGPT 4o不仅在ChatGPT平台上可用,还将通过API提供给开发者。这意味着开发者可以将ChatGPT 4o的智能集成到他们的AI应用中,开发出更加丰富的AI应用程序。

5、安全性和道德考量

Murati在发布会上也提到了安全性问题。随着实时音频和视觉技术的引入,OpenAI需要应对新的安全挑战。公司正在与政府、媒体和社会各界合作,确保这些技术的安全使用。

6、实时翻译和情感识别

在演示环节,研究员们展示了ChatGPT 4o的实时翻译和情感识别功能。Mark Chen进行了英语和意大利语的实时翻译对话,展示了ChatGPT 4o的多语言处理能力。Barrett Z则通过展示自拍照片,让ChatGPT识别其情绪,展示了模型在情感识别方面的进步。

7、编码和数据分析

在另一个演示中,研究员们展示了ChatGPT 4o在编码和数据分析方面的能力。ChatGPT 4o不仅能够理解和解释代码,还能通过视觉分析功能,帮助用户理解数据图表和其他复杂信息。

ChatGPT 4o的发布标志着OpenAI在人工智能领域的又一次重大进步。目前,GPT-4o的文本和图像功能已经在ChatGPT中开放使用,免费注册用户也可以体验该功能。

未来几周内,OpenAI会在ChatGPT Plus中推出新版语音模式GPT-4o的alpha版。让我们期待一下吧!