阿里最近开源了全新的新视觉多模态模型Qwen2-VL,这款模型的一项关键架构改进是实现了动态分辨率支持。与上一代模型Qwen-VL不同,Qwen2-VL可以处理任意分辨率的图像,而无需将其分割成块,从而确保模型输入与图像固有信息之间的一致性。

Qwen2-VL支持中文、英文、日文、韩文等众多语言,可以在Apache 2.0协议下进行商业化使用。同时阿里发布了Qwen2-VL-72B的API,帮助开发者增强或开发多模态功能的生成式AI应用。

Qwen2-VL特色功能

1、可理解20分钟以上的长视频

Qwen2-VL可理解长视频,并将其用于基于视频的问答、对话和内容创作等应用中。

2、可操作手机和机器人的视觉智能体

借助复杂推理和决策的能力,Qwen2-VL可集成到手机、机器人等设备,根据视觉环境和文字指令进行自动操作。

3、能读懂不同分辨率和不同长宽比的图片

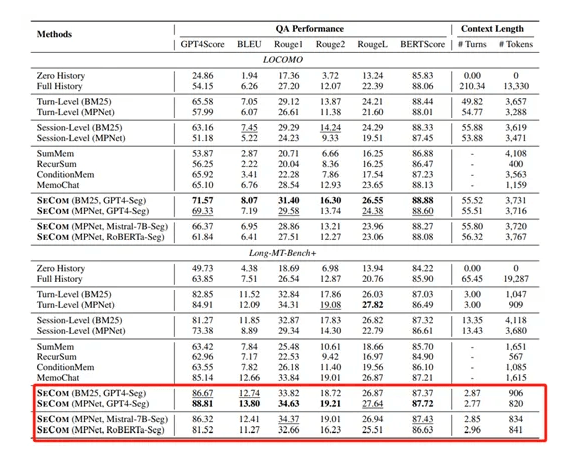

Qwen2-VL在MathVista、DocVQA、RealWorldQA、MTVQA等视觉理解基准测试中取得了全球领先的表现。

在性能评估方面,阿里从大学题目、数学、文档表格多语言文字图像的理解、通用场景下的问答、视频理解、Agent进行了综合测试。结果显示,72B的大部分性能超过了GPT-4o,仅在对综合的大学题目上和GPT-4o还有一些差距。在7B模型上,其性能与GPT-4mini的水平一样,尤其是像DocVQA之类的文档理解能力和MTVQA考察的图片中多语言文字理解能力都处于SOTA水平。

Qwen2-VL架构上的两大创新

1、实现了对原生动态分辨率的全面支持

与上一代模型相比,Qwen2-VL能够处理任意分辨率的图像输入,不同大小图片被转换为动态数量的tokens,最小只占4个tokens。这种设计不仅确保了模型输入与图像原始信息之间的高度一致性,更是模拟了人类视觉感知的自然方式,赋予模型处理任意尺寸图像的强大能力,使其在图像处理领域展现出更加灵活和高效的表现。

2、多模态旋转位置嵌入(M-ROPE)

传统的旋转位置嵌入只能捕捉一维序列的位置信息,而M-ROPE通过将原始旋转嵌入分解为代表时间、高度和宽度的三个部分。使得大规模语言模型能够同时捕捉和整合一维文本序列、二维视觉图像以及三维视频的位置信息。这一创新赋予了语言模型强大的多模态处理和推理能力,能够更好地理解和建模复杂的多模态数据能力。

目前,阿里已经展示了Qwen2-VL的多个实际应用案例,可以对一大段视频进行详细解读。另外Qwen2-VL还具备了GPT-4o的实时问答功能,让其对一些书、植物、手势等进行解读。