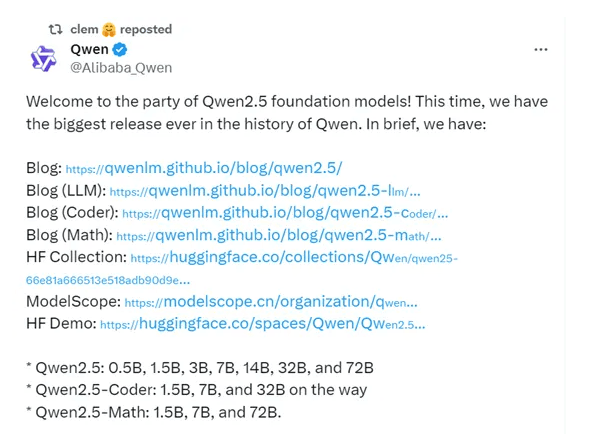

最近阿里巴巴开源发布了史上最大规模的Qwen2.5系列模型,分为基础模型Qwen2.5、专用于编码Qwen2.5-Coder和数学的Qwen2.5-Math三大类。这三大类模型包含0.5B、1.5B、3B、7B、14B、32B和72B等10多个版本,适用于个人、企业以及移动端、PC等不同人群不同业务场景的模型。

阿里还专门为不想进行繁琐的部署的人群开放了旗舰模型Qwen-Plus和Qwen-Turbo的API,帮助他们快速开发或集成生成式AI功能。

Qwen2.5系列模型介绍

Qwen2.5系列支持中文、英文、法文、西班牙文、葡萄牙文、德文、意大利文、俄文、日文等超过29种主流语言。与Qwen2类似,Qwen2.5语言模型支持高达128K tokens,并能生成最多8K tokens的内容。

1、预训练数据大幅度增长

与Qwen2相比,Qwen2.5系列的预训练数据大幅度增长达到了惊人的18万亿tokens,超过了Meta最新开源Llama-3.1的15万亿,成为目前训练数据最多的开源模型。

2、知识能力显著增强

在MMLU基准测试中,Qwen2.5与Qwen2-7/72B相比从70.3提高到74.2,从84.2提高到86.1。Qwen2.5在GPQA/MMLU-Pro/MMLU-redux/ARC-c基准测试上也有显着改进。

3、生成更符合人类偏好的响应

与Qwen2-72B-Instruct相比,Qwen2.5-72B-Instruct的Arena-Hard分数从48.1显着提高到81.2,MT-Bench分数从9.12提高到9.35。

4、数学能力获得增强

在融合了Qwen2-math的技术后,Qwen2.5的数学能力也得到了快速提升。在MATH基准上,Qwen2.5-7B/72B-Instruct的得分从Qwen2-7B/72B-Instruct的52.9/69.0提高到75.5/83.1。

此外Qwen2.5在指令跟踪、生成长文本(从1k增加到超过8K标记)、理解结构化数据(例如表格)以及生成结构化输出(尤其是JSON)方面实现了显着改进。同时对系统提示的多样性更具弹性,增强了聊天机器人的角色扮演实施和条件设置。

Qwen2.5系列模型性能测试

在MMLU-Pro、MMLU-redux、GPQA、MATH、GSM8K、HumanEval、MBPP等全球知名基准测试平台上,研究人员对于Qwen2.5-72B进行了测试。结果显示,Qwen2.5-72B在多个基准测试中击败了Meta拥有4050亿参数的最新开源Llama-3.1指令微调模型,全面超过了Mistral最新开源的Large-V2指令微调模型,成为目前最强大参数的开源模型之一。

即便是没有进行指令微调的基础模型Qwen2.5,其性能同样超过Llama-3-405B。阿里开放API的旗舰模型Qwen-Plus,其性能可以媲美闭源模型GPT4-o和Claude-3.5-Sonnet。

此外Qwen2.5系列首次引入了140亿和320亿两种新参数模型,Qwen2.5-14B和Qwen2.5-32B。性能超过了谷歌的Gemma2-27B、微软的Phi-3.5-MoE-Instruct,与闭源模型GPT-4o mini相比,只有三项测试略低其他基准测试全部超过。

自阿里发布CodeQwen1.5以来,吸引了大量用户通过该模型完成各种编程任务,包括调试、回答编程相关的问题以及提供代码建议。本次发布的Qwen2.5-Coder-7B指令微调版本,在众多测试基准中,击败了那些知名且有较大参数的模型。

本次发布的Qwen2.5-Math在更大规模的高质量数学数据上进行了预训练,包括由Qwen2-Math生成的合成数据。同时增加了对中文的支持,并通过CoT、PoT和TIR的能力来加强其推理能力。其中Qwen2.5-Math-72B的整体性能超越了Qwen2-Math-72B指令微调和著名闭源模型GPT4-o。