近日,腾讯宣布推出业界参数规模最大、效果最好的开源MoE大语言模型Hunyuan-Large。Huanyuan-large模型拥有3890亿总参数(389B)和520亿激活参数(52B),具备处理长达256K上下文能力。

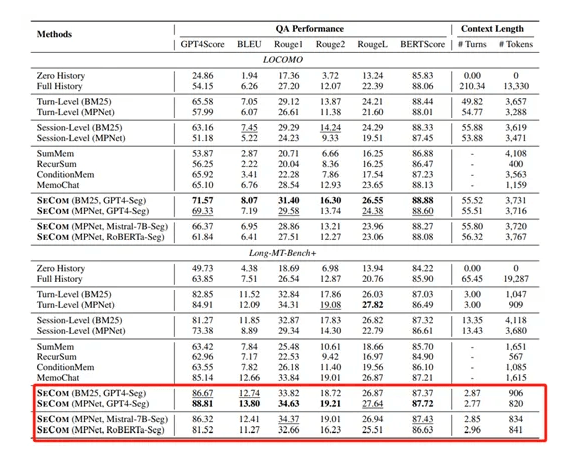

据测评结果显示,腾讯Hunyuan-Large模型在CMMLU、MMLU、CEval、MATH等多学科综合评测集以及中英文NLP任务、代码和数学等9大维度全面领先,超过Llama3.1、Mixtral等一流的开源大模型。

Hunyuan-Large采用了高效的MoE结构,使用多个专家替换了Transformer中的原始前馈网络。Hunyuan-Large包含共享专家和专用专家两种模式,不仅能够捕捉所有token所需的共同知识,还能够动态学习特定领域的知识。同时Hunyuan-Large还开发了一种新的回收路由策略,用于处理在原始top-k路由过程中被丢弃的token。这种策略通过将这些token重新分配给未超过容量的其他专家,以优化训练效率和稳定性。

其中模型技术优势如下:

1、KV缓存压缩

通过减少KV缓存的存储需求来降低内存占用,同时保持了模型对于长序列处理的能力,可以有效地减少键值对的存储空间,而不牺牲准确性或速度。

2、专家特定的学习率缩放

Hunyuan-Large采用了AdamW作为优化器,并根据批量大小调整学习率。

3、高质量合成数据

Hunyuan-Large一共使用了7万亿token数据进行了预训练,其中包括近1.5万亿的高质量和多样化的合成数据。这些合成数据的生成过程涉及四个关键步骤:指令生成、指令演化、响应生成和响应过滤。

- 指令生成:利用高质量的数据源,如网页、问答数据、代码库、书籍等,配合多样化的指令生成提示,生成覆盖多个领域的多样化指令。

- 指令演化:通过增强指令的清晰度和信息量、扩展低资源领域指令以及增加指令难度等手段,进一步提升指令的质量。

- 响应生成:利用多个专业化模型为这些演化后的指令生成信息丰富、准确的答案。

- 响应过滤:通过批评模型和自一致性检查,确保合成的指令-响应对的质量,有效去除低质量或不一致的数据。

4、学习率调度

在Hunyuan-Large的训练过程中,学习率调度贯穿三个阶段:初始的预热阶段、随后的逐渐衰减阶段,以及最后的退火阶段。

模型在初始阶段有效地探索解空间,避免过早收敛到次优的局部最小值。随着训练的进行,学习率的逐渐降低确保了模型能够向更优解收敛。在预训练的最后5%阶段,Hunyuan-Large引入了退火阶段,将学习率降低到峰值的十分之一。这有助于模型细致地调整参数,实现更高的泛化能力,从而提升整体性能。

在退火阶段之后,Hunyuan-Large还进行了长文本预训练,以增强其处理长文本的能力,逐渐增加token长度从32K增长至256K。Hunyuan-Large采用了RoPE来构建位置嵌入,并在256K预训练阶段将RoPE的基础频率扩展到10亿。

5、广泛的基准测试

在多种语言和任务上进行广泛实验,验证了Hunyuan-Large的实际应用效果和安全性。