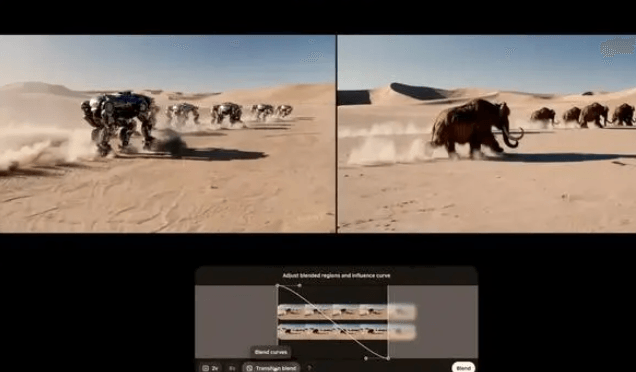

近日,OpenAI在第三天技术直播中正式发布了Sora Turbo。该模型是目前全球生成时长最高的视频模型之一,能通过文本直接生成最多20秒1080P视频,同时支持文本+图片/视频,生成特定视频内容,使得模型的生成效果更加可控。

目前,Sora已经正式进入使用阶段,ChatGPT Plus和Pro会员无需额外费用就能使用。

为了让用户能够更好地使用Sora,OpenAI还开发了全新UI,同时提供社区分享服务,用户可以把自己生成的视频分享给其他人,或者借鉴其他人的提示效果来完善自己作品。

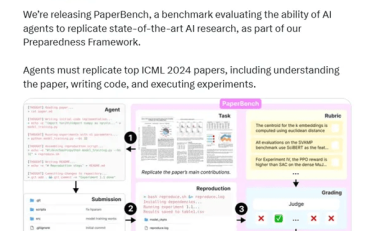

Sora核心技术介绍:

1、对Patch的应用

它允许Sora在大量的图像和视频数据上进行密集训练。从每一个存在的视频中剪出的Patch,可以被堆叠起来并输入到模型中。这种基于Patch而非视频全帧的训练方式,使得Sora能够处理任何大小的视频或图片,无需进行裁剪。这不仅增加了用于训练的数据量,也提高了输出质量。

2、采用了视频压缩网络

这是一种专门设计用来降低视觉数据维度的神经网络。通过该网络,原始视频被转换成一个在时间和空间上都经过压缩的潜在表示。Sora在这个压缩后的潜在空间内接受训练,并学习如何生成新的视频内容。同时,还训练了一个解码器模型,用于将生成的潜在表示映射回像素空间,恢复为可视化的视频帧。

对于时空潜伏斑块,在获取压缩输入视频后,OpenAI从中提取出一系列时空Patch作为转换标记。基于这种Patch表示法,Sora得以在各类视频和图像数据上进行训练,无论是不同分辨率、时长还是长宽比的素材都能轻松应对。在推理阶段,通过在适宜大小的网格中合理排列随机初始化的Patch,便能精准控制生成视频的尺寸规格。

3、融合扩散模型与Transformer架构

在模型架构设计方面,Sora巧妙地融合了扩散模型与Transformer架构,这种融合方式达成了高效且高质量的视频内容生成效果。

4、采用创新的扩散式转换器方法

这一举措有效提升了对输入图像与文本标签之间分布关系的捕捉能力。Sora还运用描述性合成描述符展开训练,这些描述符对于模拟现实场景以及规划未来行动发挥重要作用。

5、引入重新字幕技术

由于训练视频模型对大量带有相应字幕的视频有着强烈需求,OpenAI将DALL・E 3的重新字幕技术引入到Sora体系之中。首先训练出一个具备高度描述性的字幕模型,接着利用该模型为训练集中的所有视频创建文本字幕。

此外,OpenAI还借助GPT将简短的用户提示转换为篇幅更长且内容详细的字幕信息,然后将其传输给视频模型。通过这一系列技术手段的协同运作,Sora能够精准地依据用户的文本提示,生成高质量的长视频内容。