近日,Meta开源了多模式模型SPIRIT–LM,能够理解和生成语音及文本,可以非常自然地在两种模式间转换,不仅能处理基本的语音转文本和文本转语音任务,还能捕捉和再现语音中的情感和风格。

SPIRIT–LM是基于一个70亿参数的预训练文本语言模型,交错使用文本和语音数据进行训练,使模型能够自由地混合文本和语音,在任一模态中生成语言内容。

SPIRIT–LM有两个版本:基础版(Base)和表达版(Expressive)。

SPIRIT–LM基础版(BASE):专注于使用语音语义单元来处理语音数据。

SPIRIT–LM表达版(EXPRESSIVE):在语义单元的基础上增加了音高和风格单元来模拟表达性。音高标记是通过VQ-VAE模型在输入语音的基频上训练得到的,这种方法能够捕捉语音的音高特征,从而使得模型能够理解和生成具有特定音高的语音。风格标记则是通过提取语音的风格特征并进行聚类得到的,这些标记能够帮助模型捕捉语音的风格特征。

对于两个版本的模型,文本数据都使用了子词BPE标记进行编码,这是一种高效的文本编码方式,能够处理任意词汇包括未知词。而对于语音数据,则采用了HuBERT模型作为语音编码器,将语音转换为语义语音标记,能够在没有标签的情况下从大量语音数据中学习到有用的表示。

此外,SPIRIT-LM还使用了“TEXT”和“SPEECH”特殊标记来区分文本和语音标记。在训练过程中,这些特殊标记帮助模型识别输入数据的模态,从而正确地处理文本或语音输入。

当模型在对齐的语音-文本语料库中进行训练时,它会在单词边界随机触发模态变化,使得语音标记和文本标记在模态变化边界处交错。这种交错训练方法有助于模型学习语音和文本之间的对应关系,从而提高跨模态的理解和生成能力。

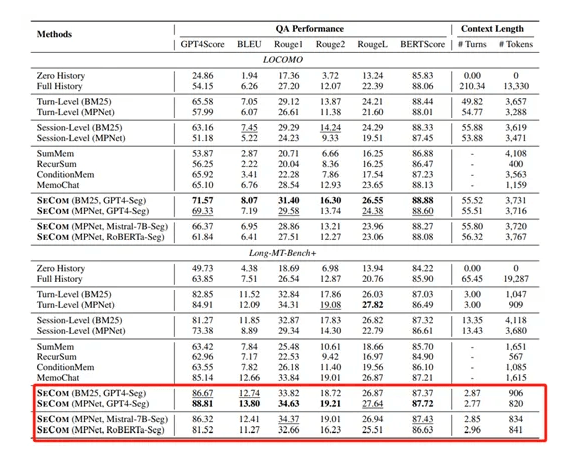

为了评估SPIRIT-LM性能,Meta在sWUGGY、sBLIMP、StoryCloze等任务中对SPIRIT-LM进行了语音和文本理解综合测试,都能够准确地生成正确的序列。而在跨模态任务上也展现了良好的性能,在自动语音识别和文本到语音任务中,SPIRIT-LM能够根据少量示例进行特定任务的建模。