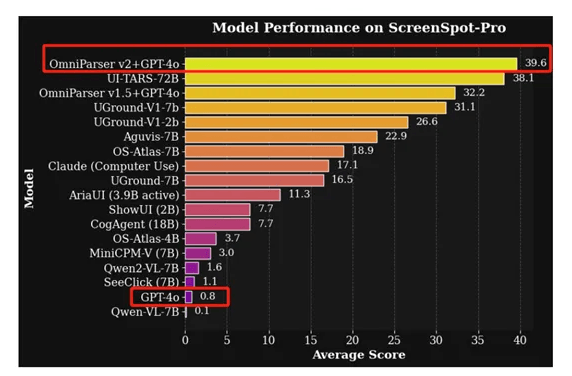

最近,微软在官网发布了视觉Agent解析框架OmniParser最新版本V2.0,可将OpenAI(4o/o1/o3-mini)、DeepSeek(R1)、Qwen(2.5VL)、Anthropic(Sonnet)等大模型,变成可在计算机使用的AI Agent。相比前代版本,OmniParser V2在检测更微小可交互元素时精度更高、推理速度更快。

OmniParser V2通过将用户界面从像素空间“标记化”解析为结构化元素,使得大模型能够理解和操作这些元素。这有点类似于自然语言处理中的分词操作,但针对的是视觉信息。通过这种方式,大模型可以在解析后的可交互元素集合上进行基于检索的下一步动作预测。

简单来说,用户可以把OmniParser V2看成是大模型的“眼睛”,可以让其更好地理解和操作复杂的用户界面。

除此之外,微软还开源了omnitool,这是一个基于Docker的Windows系统,涵盖屏幕理解、定位、动作规划和执行等功能,也是将大模型变成Agent的关键工具。

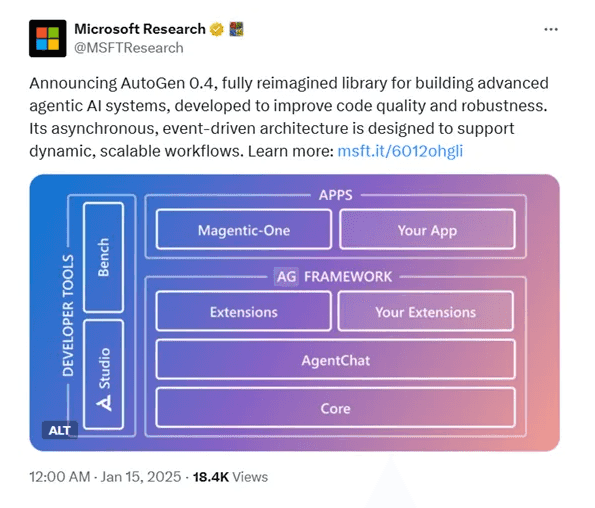

OmniTool是一个集成化工具,支持开箱即用,可以将DeepSeek-R1、GPT-4o、Qwen-2.5VL等模型变成Agent,一共由OmniParser V2、OmniBox和Gradio三大块组成。

OmniBox:一个基于Docker的轻量级Windows 11虚拟机。

与传统的Windows虚拟机相比,OmniBox占用的磁盘空间减少了50%,同时提供了相同的计算机使用API。用户可以在更小的资源消耗下,快速搭建和运行GUI自动化任务的测试环境。这对于硬件资源有限的开发者来说非常方便。

Gradio:提供了一个交互界面,可以帮助开发者轻松地与V2和大模型进行交互,快速测试和验证自动化任务的效果。

Gradio UI的使用非常简单,只需要在本地机器上启动OmniBox和Gradio服务器,然后通过浏览器访问Gradio UI提供的界面即可。

OmniParser核心架构:

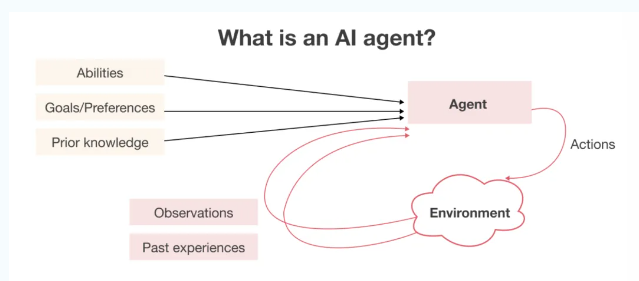

OmniParser的核心思想是将用户界面的视觉信息,转化为易于理解和操作的结构化数据。

这个过程比较复杂,需要多个模块协作才能完成。首先,OmniParser需要从用户界面截图中识别出所有可交互的元素,例如,按钮、图标和输入框等;接下来OmniParser不仅要识别这些元素的位置,还要理解它们的功能和语义。

为了实现这些目标,OmniParser采用了多阶段的解析流程。在第一阶段,可交互区域检测模块利用深度学习技术,从用户界面截图中识别出所有可能的交互点。这一模块的训练数据集,包含了来自流行网页的67,000张独特截图,每张截图都标注了从DOM树中提取的可交互区域的边界框。

通过使用模型对这些数据进行训练,OmniParser能够以极高的准确率识别出屏幕上的可交互元素,并为每个元素分配一个唯一的标识符。该模块的目标是为每个检测到的图标生成一个描述其功能的文本。微软开发了一个包含7,185个图标描述对的数据集,并使用BLIP-v2模型对其进行微调,能够更准确地描述常见应用图标的语义信息。

OmniParser的第三个重要模块是结构化表示与动作生成模块。这一模块将前两个模块的输出整合在一起,形成一个结构化的、类似DOM的UI表示。不仅包含了叠加了边界框和唯一ID的截图,还包含了每个图标的语义描述。这可以帮助DeepSeek-R1、GPT-4o、Qwen-2.5VL等模型更轻松地理解屏幕内容,并专注于动作预测。