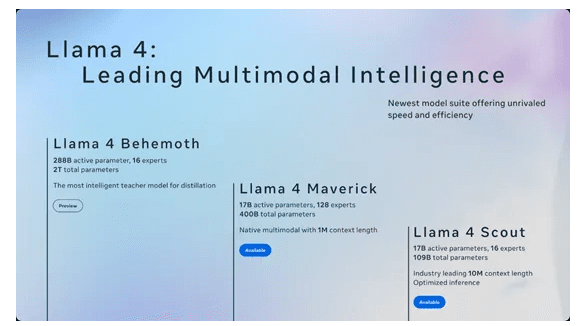

近日,美国科技巨头Meta公司发布了其大型语言模型Llama的最新版本,Llama 4 Scout与Llama 4 Maverick。该模型是Meta迄今为止最先进的模型,也是同类产品中多模态性最强的模型。此外Meta还预览了其迄今最强大最智能的模型——Llama 4 Behemoth,是“新模型中的教师”。

Llama 4模型是Llama系列模型中首批采用混合专家(MoE)架构的模型,这一架构也是DeepSeek系列模型采用的架构,与传统的稠密模型相比,在MoE架构中,单独的token只会激活全部参数中的一小部分,训练和推理的计算效率更高。

Meta在声明中表示,Llama 4是一个多模态AI系统,能够处理和整合文本、视频、图像、音频等多种数据类型,并能在不同格式之间实现内容转换。

Llama 4系列目前包含两个版本:Scout和Maverick。

Llama 4 Scout拥有170亿个活跃参数、16个“专家”模型和1090亿个总参数,而Llama 4 Maverick则具备170亿个活跃参数、128个“专家”模型和高达4000亿的总参数量。这种混合专家架构通过将复杂任务分解为子任务,并由专门的“专家”模型处理,显著提升了模型的训练和推理效率。Meta表示,这种设计使得Llama 4在处理多模态数据(如文本、图像、视频和音频)时表现出色,能够在不同格式之间灵活转换内容。

1、Llama 4 Scout

Llama 4 Scout是一个专家混合架构模型,一共有1090亿参数。其中,有170亿活跃参数和16个专家路由,能在单个H100 GPU上使用,具备原生多模态的能力,可以处理文本和图像,支持最多8张图像的输入。

架构创新方面,Llama 4 Scout使用了无位置交叉嵌入的交错注意层NoPE。传统的Transformer架构通过位置编码将每个单词的位置信息嵌入到模型中,从而使模型能够区分不同位置的单词。但这种显式的位置编码方法在长度泛化方面存在局限性。例如,当模型在训练时接触到的序列长度较短,在测试时需要处理更长的序列时,显式位置编码可能无法有效地泛化到这些未见过的长度。而NoPE可以很好解决这个难题。

训练数据方面,Llama 4 Scout使用了30万亿token数据,包括文本、图像、视频,比之前开源的Llama 3高两倍。

此外,Llama 4 Scout在预训练阶段还特别注重多语言能力的培养,在200种语言上进行了训练,其中包括超过100种拥有超过10亿标记的语言,使得Llama 4 Scout在处理跨语言任务时具备了强大的语言理解和生成能力。

2、Llama 4 Maverick

Llama 4 Maverick同样是专家混合模型,一共有4000亿参数。其中,170亿参数处于活跃状态和128个专家路由。同样可以在单个H100运行,不过只有100万上下文。

Maverick使用的训练方法和数据与Scout差不多。根据公布的测试数据显示,Maverick在MMLU/Pro、GPQA、DocVQA、MathVista超过了谷歌的Gemini 2.0和OpenAI的GPT-4o,可以媲美DeepSeek最新开源的V3模型。

训练创新方面,Meta在训练Maverick时,用了一种新办法来优化训练流程包括三个步骤:先进行轻量级监督微调(SFT),接着开展在线强化学习(RL),最后做轻量级直接偏好优化(DPO)。

在SFT和DPO这两个步骤,Meta剔除了超过50%被标记为“简单”的数据,并在剩余更具挑战性的数据集上进行轻量级SFT。在随后的多模态在线RL阶段,通过精心挑选更具挑战性的提示,实现了性能的显著提升。

此外,Meta实施了连续在线RL策略,即交替进行模型训练,然后利用训练好的模型持续筛选并仅保留中等至较难难度的提示。

Meta表示,Scout和Maverick只是开源的首批Llama 4系列模型。正在训练一个总参数2万亿,活跃参数2880亿活跃参数和16个专家路由的教师模型——Llama 4 Behemoth。

Llama 4 Behemoth主要用于蒸馏、微调小模型,Llama 4 Maverick便是通过它完成的。为了实现性能的最大化,Meta对SFT数据进行大幅删减,要剪掉95%的数据,而较小的模型仅需剪掉50%,以此来实现对质量和效率的必要关注。

Llama 4的发布不仅是Meta在AI领域的一次重要尝试,也为开源人工智能的发展提供了新的方向。混合专家架构的应用,标志着AI模型设计从单一任务向多任务协同的转变,为未来更高效、更智能的AI系统奠定了基础。