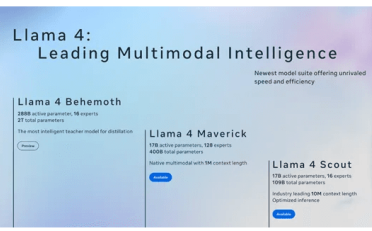

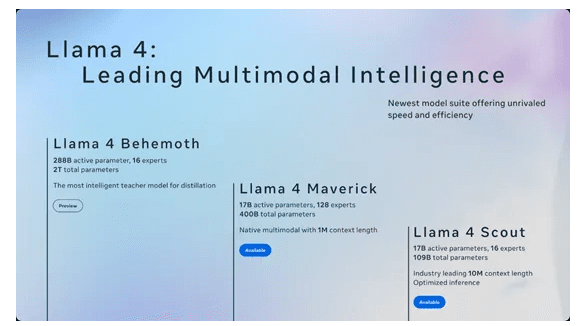

目前,亚马逊云科技已经支持多种模型的使用,如DeepSeek、Llama 2、Llama 3等,其中Llama 3是专为构建、实验和负责任地扩展生成式人工智能应用程序而设计的,提供8B和70B两种参数。Amazon SageMaker AI简化了Llama 3.3 70B等复杂模型的部署,提供一系列旨在优化性能和成本效率的功能。本文就来详细地带大家来了解一下通过SageMaker JumpStart AI部署Llama 3模型教程。

Llama 3模型:

- Llama 3 8B非常适合有限的计算能力和资源以及边缘设备。该模型擅长文本摘要、文本分类、情感分析和语言翻译。

- Llama 3 70B非常适合内容创建、对话式AI、语言理解、研究开发和企业应用程序。该模型擅长文本摘要和准确性、文本分类和细微差别、情感分析和细微差别推理、语言建模、对话系统、代码生成和遵循指令。

本文选择的是Llama 3.3 70B模型,下面就一起来看下。

一、亚马逊云科技免费云服务推荐

点击获取:亚马逊云科技官网

1、亚马逊云科技免费云服务器

亚马逊云科技现为用户提供的免费云服务器(Amazon EC2)服务,可免费试用12个月,包括每月750个小时的Linux和Windows t2.micro实例。Amazon EC2访问可靠、可扩展、可用性高达99.99%。

2、亚马逊云科技免费云存储

亚马逊云科技免费数据库提供的方案是1核1G内存、20GB通用型(SSD)、20GB数据库备份和数据库、自动备份/自动数据库软件升级、最多可扩展32 vCPU/244GB的内存。适用于MySQL、PostgreSQL、MariaDB、Oracle BYOL、SQL Server数据库引擎,免费试用12个月。

3、亚马逊免费无服务器计算

亚马逊免费无服务器计算(Amazon Lambda)是一种免费使用的无服务器计算服务,无需管理服务器,自动扩展应用程序,通过毫秒计量优化成本,任意规模都能获得—致的超高性能,每月100万次免费请求、每月高达320万秒计算时间,永久免费。

新用户注册亚马逊云科技账户,即可免费使用以上云服务产品,长达12个月。

相关推荐:《如何注册亚马逊AWS账号》

二、通过SageMaker JumpStart UI部署Llama 3.3 70B

SageMaker JumpStart是亚马逊云科技推出的一个机器学习中心,可帮助加快用户的ML之旅。使用SageMaker JumpStart,用户可以评估、比较和选择预训练的基础模型,包括Llama 3模型。

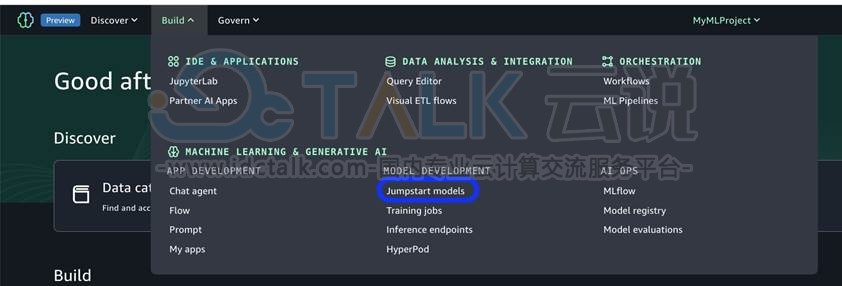

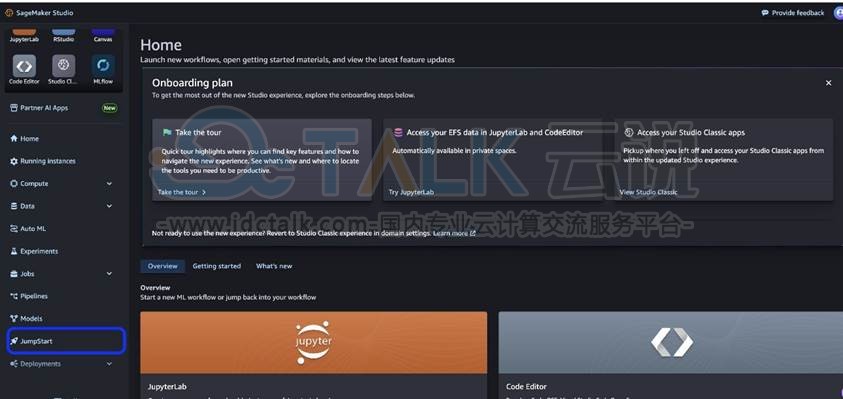

1、进入亚马逊云科技官网,在SageMaker Unified Studio中,在“构建”菜单上选择“启动模型”。

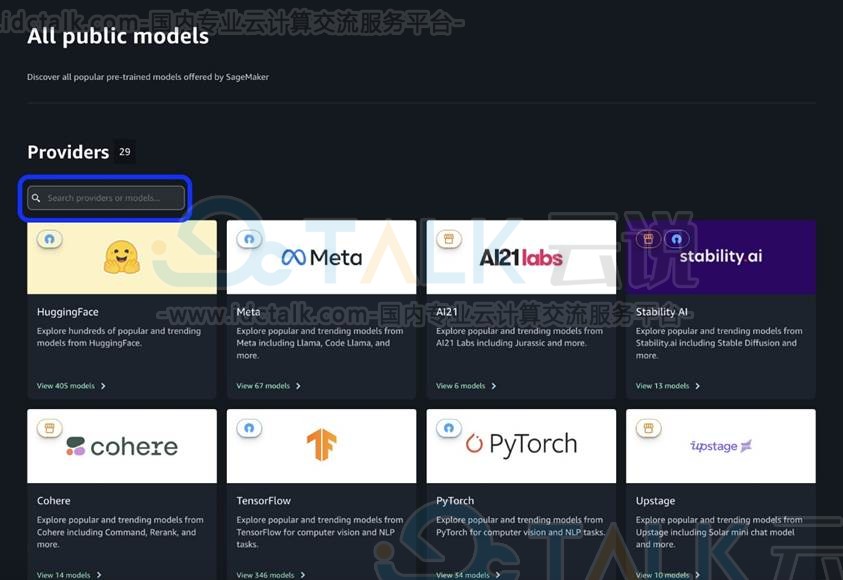

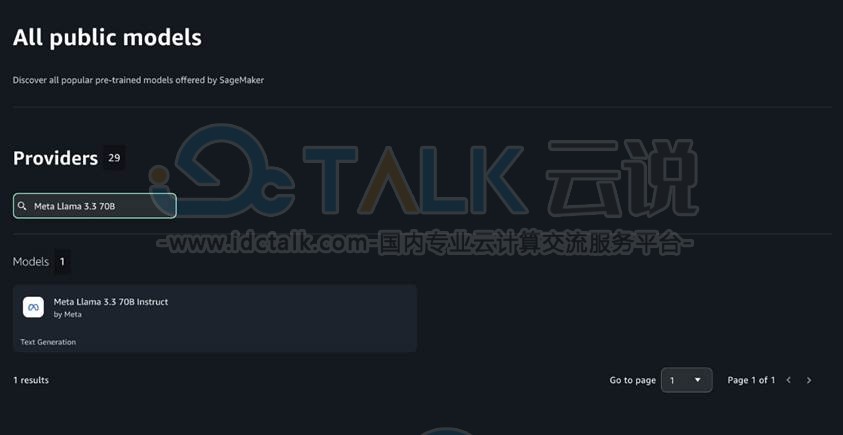

2、通过在左上角的搜索框中搜索“Meta-llama-3”来找到Llama 3型号。

3、选择Meta Llama 3.3 70B模型。

4、选择部署。

5、接受最终用户许可协议(EULA)。

6、选择实例类型(ml.g5.48xlarge或ml.p4d.24xlarge)。

等待端点状态显示为InService。现在就可以使用该模型运行推理了。

三、使用SageMaker Python SDK部署Llama 3.3 70B

对于希望自动部署或与现有MLOps管道集成的团队,就可以使用以下代码,使用SageMaker Python SDK部署模型:

from sagemaker.serve.builder.model_builder import ModelBuilder

from sagemaker.serve.builder.schema_builder import SchemaBuilder

from sagemaker.jumpstart.model import ModelAccessConfig

from sagemaker.session import Session

import logging

sagemaker_session = Session()

artifacts_bucket_name = sagemaker_session.default_bucket()

execution_role_arn = sagemaker_session.get_caller_identity_arn()

js_model_id = "meta-textgeneration-llama-3-3-70b-instruct"

gpu_instance_type = "ml.p4d.24xlarge"

response = "Hello, I'm a language model, and I'm here to help you with your English."

sample_input = {

"inputs": "Hello, I'm a language model,",

"parameters": {"max_new_tokens": 128, "top_p": 0.9, "temperature": 0.6},

}

sample_output = [{"generated_text": response}]

schema_builder = SchemaBuilder(sample_input, sample_output)

model_builder = ModelBuilder(

model=js_model_id,

schema_builder=schema_builder,

sagemaker_session=sagemaker_session,

role_arn=execution_role_arn,

log_level=logging.ERROR

)

model= model_builder.build()

predictor = model.deploy(model_access_configs={js_model_id:ModelAccessConfig(accept_eula=True)}, accept_eula=True)

predictor.predict(sample_input)设置自动缩放和缩放到零。

用户可以选择设置自动缩放,以便在部署后缩减为零。

相关推荐: